一、研究背景

叶面积指数(LAI)是植被冠层结构和光合效率的关键指标,对大豆高产品种培育、作物生长监测及产量预测至关重要。传统LAI测量方法耗时、空间覆盖有限,无法满足现代农业高频、大范围监测需求。遥感技术的发展推动了LAI数据获取方式的变革:无人机(UAV)具备厘米级高分辨率,能精准捕捉田间尺度作物异质性,但空间覆盖范围有限;PlanetScope卫星星座可提供3米分辨率的全球每日影像,覆盖范围广、重访频率高,适合区域尺度监测,但田间尺度LAI估算精度受限。因此,如何有效融合高分辨率无人机数据与广覆盖卫星数据,解决跨尺度数据融合中的分辨率差异、光谱响应不一致等问题,实现大范围、高精度的大豆LAI监测,是精准农业领域的关键研究难题。

二、研究方法

本文提出LAI-TransNet框架,融合物理模型与迁移学习,实现多源遥感数据支持下大豆叶面积指数(LAI)的高精度跨尺度估算。首先,基于PROSAIL模型生成模拟反射率数据(UAV-Sim),结合实测LAI构建基准数据集,比较传统机器学习、深度学习和迁移学习模型性能,建立无人机尺度LAI估算基线。随后,通过引入作物先验参数降低泛化偏差,利用CycleGAN进行光谱域对齐以削弱传感器差异,并结合双伪标记迭代策略增强模型在动态生长环境中的鲁棒性。最终,基于无人机尺度最优模型经二次迁移学习,实现至卫星尺度的扩展,生成大范围LAI估算结果并与实测数据及其他模型进行对比评估,确保跨尺度估算的准确性与一致性。该成果为多源遥感协同监测与精准农业管理提供可推广的技术路径,实现从田间精细观测到区域尺度LAI监测的一致性连接。

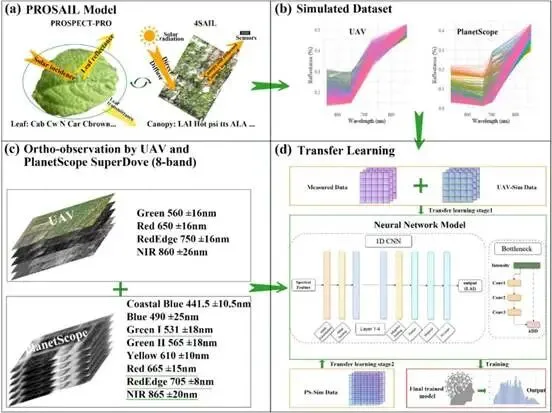

图1 LAI预测的迁移学习过程:(a)PROSAIL模型利用叶片和伞冠参数模拟伞层反射率;(b)训练数据集的反射率曲线模拟;(c)传感器观测到的光谱带;(d)利用模拟和测量数据进行神经网络的两阶段迁移学习。

三 、研究结果

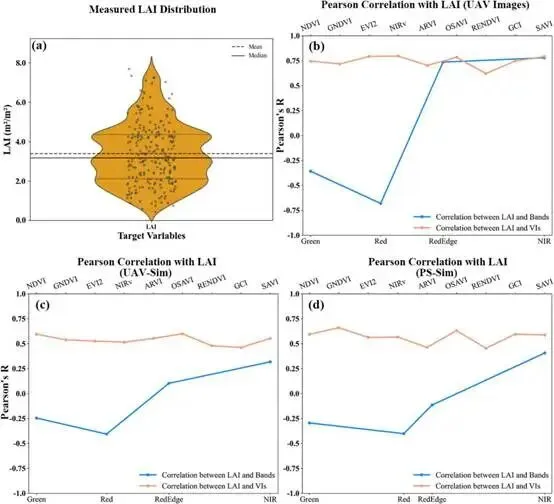

(1)遥感观测与LAI之间的相关性:通过敏感性分析,利用PROSAIL模拟数据(PS-Sim和UAV-Sim)及无人机影像数据,探讨LAI与反射率和光谱指数之间的关系。分析表明,不同数据源在反映大豆冠层LAI时存在显著差异。图2(a)为实测LAI,范围为0–8m²/m²,均值为3.4m²/m²。图2(b)–(d)为LAI与PROSAIL(PS-Sim和UAV-Sim)、UAV和PlanetScope光谱中心波段反射率之间的LAI相关系数(r),以及包括NDVI和EVI在内的9个VI。在无人机影像中,红边(750nm)和近红外(860nm)波段与LAI呈强正相关(r分别为0.74和0.78);而PROSAIL模拟的无人机数据(UAV-Sim)在相同波段相关性较弱(r为0.10和0.32),PlanetScope卫星数据相关性最弱(近红外波段r=0.32)。这表明空间分辨率差异及模拟数据对真实环境变异刻画不足,给跨尺度LAI估算带来挑战。相比之下,所分析的9种植被指数(VI)在所有数据源中均与LAI保持较强正相关,无人机影像中平均r达0.75(EVI为0.80),模拟数据平均为0.65。VI显著增强了光谱信号与LAI之间的关联,有利于提升模型预测能力与可解释性。

图2 测量LAI的统计分布及对各种变量的相关分析。(a)237个测量LAI值的分布;(b–d)皮尔逊相关系数:LAI与单波段反射率、无人机影像得出的VI以及PROSAIL模型模拟之间的相关系数。

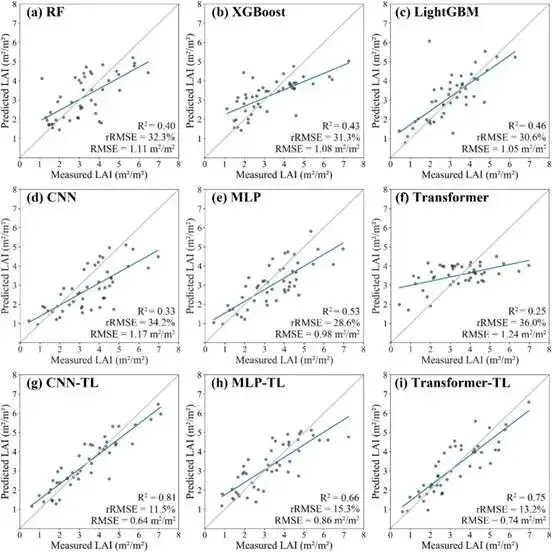

(2)第一阶段:无人机规模LAI基准开发:评估了统计机器学习、深度学习及迁移学习模型在无人机尺度LAI反演中的性能。结果表明(表1),基于无人机模拟数据集,CNN模型表现最优(R²=0.94,RMSE=0.12m²/m²),其次为随机森林(R²=0.93)。而XGBoost、LightGBM等传统模型表现相对较弱。引入实测数据构建混合数据集(UAV-Sim_Measured)后,如图7所示,所有模型性能均下降,其中RF模型R²下降了53.8%,显示数据异质性带来的挑战。在此条件下,迁移学习模型展现出显著优势:CNN-TL取得最佳性能(R²=0.81),明显优于非迁移学习的MLP(R²=0.53)和Transformer(R²=0.25)等模型。可见,CNN在模拟数据上具有最高精度,而迁移学习方法在融合实测与模拟数据时更具鲁棒性,为后续跨尺度LAI估算提供了有效的基准模型。

表1 无人机模拟及其他模型在LAI预测任务中的建模性能

图3 使用UAV-Sim_Measured数据集不同模型间LAI预测表现的比较。散点图显示了预测与测量的LAI,分别针对(a)RF,(b)XGBoost,(c)LightGBM,(d)CNN,(e)MLP,(f)Transformer,(g)CNN-TL,(h)MLP-TL,以及(i)Transformer-TL。每个子图显示数据点、线性回归拟合(蓝线)、1:1参考线(灰虚线),并给出R2,RMSE(m2/m2),以及rRMSE(%)。

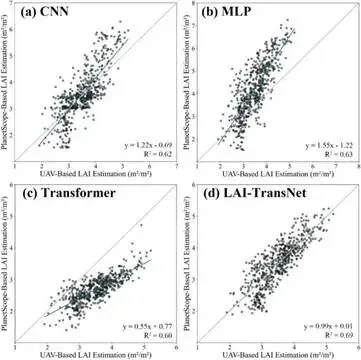

(3)第二阶段:跨尺度模型优化:分析了三种深度学习模型与LAI-TransNet模型在PS-Sim数据集上的表现。如表2所示,CNN、MLP和Transformer模型各自获得了R2值为0.99,表明这些模型预测准确度卓越且一致。相比之下,LAI-TransNet模型的性能相对较低,R2值为0.96。总体表明,所有模型在PS-Sim数据集上的准确率均较高。进一步评估了LAI估算在无人机与卫星(PlanetScope)尺度间的一致性(图4)。基于无人机数据,各模型估算的LAI范围为1–6m²/m²。相比之下,基于卫星数据的估算范围因模型而异:CNN为1–7m²/m²,MLP为1–8m²/m²,Transformer为1–5m²/m²。不同模型在跨尺度一致性上表现不同。CNN与MLP均呈现中等的相关性(R²≈0.62–0.63),但存在系统性的高估或低估。Transformer虽相关性稍弱(R²=0.60),但表现为持续低估。本研究所提出的LAI-TransNet模型取得了最优的一致性结果,其R²为0.69,且回归线(y=0.99x+0.01)与1:1线高度吻合,表明其在1–6m²/m²范围内实现了无人机与卫星尺度LAI估算的高度一致。

表2 PS-Sim及其他模型在LAI预测任务中的建模性能

图4 四个深度学习模型基于PlanetScope的LAI估计与基于无人机的LAI估计(单位m2/m2)的散点图比较。(a)CNN,(b)MLP,(c)Transformer,(d)LAI-TransNet。每个子图包含一条蓝色回归线和一条灰色1:1参考线,以评估两个估计来源之间的一致性。

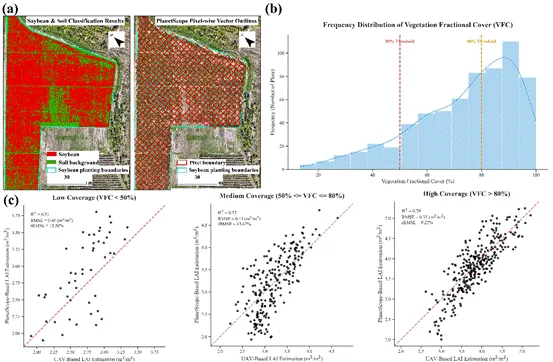

(4)像素纯度消融研究:为评估亚像素混合效应,本研究基于高分辨率无人机影像计算了每个PlanetScope像素内的植被比例。结果显示,研究区域内无纯植被像素,植被比例介于40%-85%。按植被比例将像素划分为高(>80%)、中(50–80%)、低(<50%)三个纯度等级,并对比了模型在各等级下的性能(图5)。模型表现随像素纯度下降而显著降低:高纯度等级下取得最佳性能(R²=0.70,RMSE=0.35m²/m²,rRMSE=9.22%);中等纯度时性能下降(R²=0.52,RMSE=0.44m²/m²,rRMSE=13.67%);低纯度等级下表现最弱(R²=0.31,RMSE=0.45m²/m²,rRMSE=15.58%)。该结果明确了亚像素混合是影响跨尺度LAI估算精度的关键因素。

图5 大豆叶面积指数估算的跨尺度分析。图(a)展示了基于无人机RGB影像采用RF生成的豆类作物与土壤背景分类图,其上叠加了从PlanetScope影像中提取的像素级矢量边界。图(b)呈现PlanetScope影像中单像素的大豆面积比例(植被占比),该指标可量化评估像素纯度。图(c)展示基于无人机与PlanetScope影像反射率的LAI预测结果,揭示不同植被覆盖条件下预测性能的变化规律。

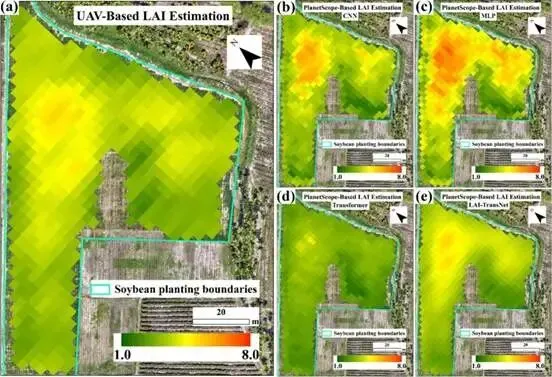

(5)利用深度学习模型与LAI-TransNet在PlanetScope图像上的LAI映射比较:基于无人机基准LAI图(CNN-TL生成,图9a)显示,研究区域内LAI空间分布不均,高值区(约6.0m²/m²)集中于中南部,低值区(约1.0m²/m²)位于北侧与西侧边缘。利用PlanetScope影像,我们对比了CNN、MLP、Transformer及LAI-TransNet模型绘制的LAI图(图9b-e)。

CNN模型能捕捉中南部的高LAI趋势,但高估了北部数值且空间变异性较弱;MLP模型呈现更宽的动态范围,但普遍高估且梯度不明显;Transformer模型输出过于均匀,未能有效反映高值区。相比之下,LAI-TransNet生成的LAI图与无人机参考图高度一致,准确再现了高、低值区的空间分布与平滑梯度,展现出最优的空间一致性与细节还原能力,与此前的定量评估结果相吻合。

图6 基于不同数据源和模型的LAI空间分布图。(a)基于无人机的LAI参考图,采用最优模型生成,空间分辨率统一为3米。(b)-(e)基于PlanetScope的LAI分布图分别使用CNN、MLP、Transformer和LAI-TransNet模型生成。所有地图均标注大豆种植边界,并有一个统一的颜色条,范围从1.0米到8.0m2/m2表示标准化的LAI值,便于模型间空间分布差异的比较。

四、创新点

(1)提出LAI-TransNet两阶段迁移学习框架,先基于PROSAIL模拟数据与实测数据建立UAV尺度基准,再经跨域映射微调适配PlanetScope数据,解决跨尺度估算难题。

(2)融入大豆专属PROSAIL先验参数,结合CycleGAN实现光谱域对齐与双伪标记策略,降低模型偏差,提升动态作物场景下的鲁棒性。

(3)融合UAV高分辨率、PlanetScope广覆盖数据及9种植被指数,抑制噪声与土壤干扰,增强光谱与LAI关联性,提升数据稀缺场景下的估算准确性。

五、研究结论

本研究提出了LAI-TransNet,这是一个采用两阶段迁移学习框架、包含特征分布对齐的深度神经网络。该模型将LAI预测从有限的田间测量大豆地块数据和小区域无人机影像扩展到高分辨率PlanetScope影像,解决了精准农业大规模大豆生长监测中的数据异质性和稀缺性挑战。在第一阶段(无人机尺度),迁移学习模型CNN-TL在融合模拟与实测数据的数据集上表现最优(R²=0.81),显著优于传统随机森林(R²=0.40)与普通CNN模型,成功构建了高精度LAI估算基准。在第二阶段(卫星尺度),模型经跨域优化后,在模拟数据上达到R²=0.96,并在实际PlanetScope影像的跨尺度预测中实现了最优的一致性(R²=0.69),性能超越CNN、MLP及Transformer等对比模型。结果表明,LAI-TransNet通过有效的特征对齐与迁移机制,显著提升了从田间到区域尺度的LAI估算鲁棒性与准确性,为精准农业提供了可扩展的可靠解决方案。

文献来源

QingLi,YananWei,DaleiHao,WeijianYu,YeluZeng,

Transferlearning-basedsoybeanLAIestimationsbyintegratingPROSAIL,UAV,andPlanetScopeimagery,ArtificialIntelligenceinAgriculture,Volume16,Issue1,2026,Pages365-380,ISSN2589-7217,https://doi.org/10.1016/j.aiia.2025.10.018.

转自绿水智慧农业

监制:王丽娇